Abstract

Die fortschreitende Digitalisierung in allen Bereichen unserer Gesellschaft sorgt für einen stetigen Strom von Daten. Experten beschreiben diese als das „Öl der Moderne“. So wird beispielsweise der Marktwert von Geodaten aus mobilen Anwendungen auf bis zu 100 Milliarden $ geschätzt. Um dieses enorme Potential voll ausschöpfen zu können, müssen die gigantischen Datenmengen auf effiziente Weise ausgewertet werden. Dieser Aufsatz soll einen ersten Überblick über die Anwendungsbereiche sowie die gängigsten Techniken der „Data Analysis“ geben.

Stichworte

Data Analysis, Quality Analysis, Data Analytics, Big Data

Motivation / Auslöser

Im Zuge der zunehmenden Digitalisierung von Wirtschaft und Gesellschaft werden immer größere Mengen von Daten aus unterschiedlichsten Quellen gesammelt. Das Potential der Entwicklung in den Bereichen Industrie 4.0, Internet of Things und Big Data kann allerdings nur dann voll ausgereizt werden, wenn Möglichkeiten gefunden werden, die riesigen Datenmengen effizient und zielgerichtet nach Mustern und Optimierungsmöglichkeiten zu durchleuchten. Die Methoden und Vorgehensweisen zur Gewinnung solcher Erkenntnisse werden unter dem Begriff „Data Analysis“ bzw. „Quality Analysis“ zusammengefasst und von Firmen wie z.B. der GEMMACON als Dienstleistung angeboten. Obwohl die Methoden der Data Analytics derzeit noch vor allem in den Bereichen des E-Commerce, der sozialen Medien sowie im Bank- und Versicherungswesen zum Einsatz kommen (Mustererkennung, Erstellung von Empfehlungen für weitere Produkte (siehe Amazon)), werden inzwischen auch in Branchen der „Realwirtschaft“ wie der Produktionsbranche (Industrial Internet of Things) oder der Automobilbranche (autonomes Fahren) Anstrengungen unternommen, die Digitalisierung zu fördern und die Potentiale der Data Analytics zu nutzen.

Stand der Technik

Bereits vor einigen Jahren zeigte eine Analyse die weit vorangeschrittene Verbreitung von Data-Analytics-Techniken in der Industrie (Russom, 2011). So gaben 74% der befragten Umfrageteilnehmer an, bereits eine Form von Data- oder Advanced-Analytics einzusetzen. Beinahe die Hälfte davon verwendete die Methoden mit „Big Data“-Architekturen. Die drei Hauptanwendungsbereiche und gleichzeitig die Bereiche in denen das größte Potential gesehen wird, sind laut der Studie vor allem Advanced Analytics, wie z.B. „predictive analysis“, data mining oder statistische Analysen bis hin zu Methoden des Machine Learning und der künstlichen Intelligenz, gefolgt von Advanced-Visualization-Werkzeugen zur Darstellung von Millionen von Datenpunkten und Echtzeitdatenanwendungen wie Dashboards oder Anwendungen, die in Echtzeit auf Ereignisse innerhalb des Unternehmens reagieren.

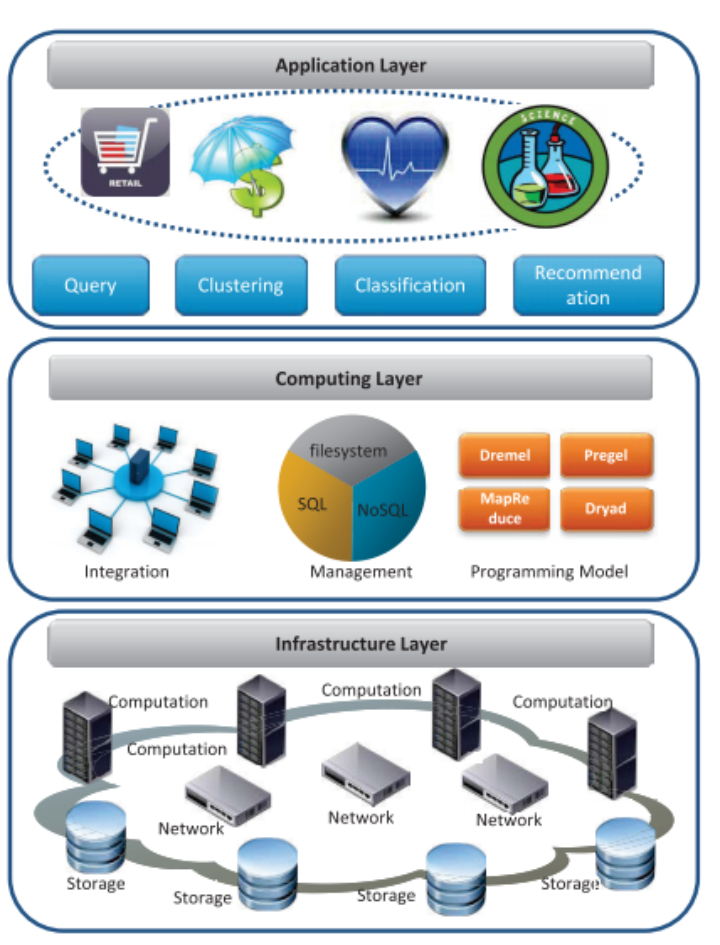

Um die genannten Methoden zuverlässig und strukturiert einsetzen zu können, setzen immer mehr Unternehmen auf (Big-)Data-Wertschöpfungsketten. In (Hu, Wen, Chua, & Li, 2014) wird der grundsätzliche Aufbau einer solchen Kette beschrieben. Die Architektur wird dabei in vier Felder unterteilt:

- Datengenerierung: Früher meist aus unternehmensinternen Datenbanken, heute zunehmend aus öffentlich zugänglichen Informationsquellen (APIs), die von Regierungen bzw. größeren Unternehmen zur Verfügung gestellt werden, oder „Social Media“.

- Die Datenerfassung aus den in 1 genannten Quellen: z.B. über Logfiles oder Webcrawler, im Falle des Internet of Things zunehmend auch über Sensorik und RFID-Chips.

- Datenspeicherung: Hier gibt es derzeit eine Vielzahl an Auswahlmöglichkeiten für Datenbanksysteme, einige Beispiele sind MongoDB, SimpleDB und CassandraDB sowie Frameworks wie Hadoop.

- Datenanalyse: Wie oben bereits angesprochen gibt es eine Vielzahl von Methoden zur Erkenntnisgewinnung aus den gespeicherten Daten. Auf einige der am weitesten verbreiteten Methoden wird im nächsten Kapitel genauer eingegangen.

Frameworks wie Hadoop ermöglichen die Verteilung der Berechnungsvorgänge auf verteilte Systeme (al., 2014).

Analyse, Diskussion und Bewertung

Sinn und Zweck des Einsatzes von „Data Analytics“ ist es, Daten aus einer Datenbank zu extrapolieren und zu interpretieren bzw. herauszufinden, wie die Daten am produktivsten genutzt werden können. Hierzu muss zunächst überprüft werden, ob die Daten gültig sind. Dann können entweder aus der Historie der Daten Diagnosen für bestimmte Probleme ermittelt oder anhand von Mustern aus den bereits bestehenden Daten Empfehlungen und Ratschläge für Entscheidungen ausgesprochen und Vorhersagen über zukünftiges Verhalten z.B. von Systemen und Anlagen getroffen werden. Es lassen sich drei Arten von „Data Analytics“ anhand ihrer Ziele unterscheiden:

- „Descriptive Analysis“ nutzt historische Daten, um Systeme zu beschreiben. Zum Beispiel können Regressionen verwendet werden, um Trends in Datensätzen zu identifizieren, die dann mithilfe von Visualisierungen präsentiert werden können. Zusätzlich können Datenmodelle entworfen werden, um Daten effizient zu sammeln, zu speichern und zu verarbeiten.

- „Predictive Analysis“ konzentriert sich darauf, Wahrscheinlichkeiten und Trends von zukünftigen Ereignissen vorherzusagen. Hierzu werden Methoden der Statistik wie z.B. lineare oder logistische Regressionen verwendet. Zudem können mithilfe von „Data Mining“ Muster ermittelt werden, um weitere Vorhersagen treffen zu können.

- „Prescriptive Analysis“ nutzt Simulationsmethoden, um das Verhalten von komplexen Systemen zu modellieren und deren Verhalten vorhersagen zu können bzw. das System zu optimieren.

Um diese Ziele zu erreichen, wird auf verschiedene Arten von Algorithmen und Werkzeugen zurückgegriffen. Die am häufigsten verwendeten Methoden sind:

- Die Visualisierung von Daten erfolgt meist mithilfe von speziellen Frameworks (z.B. 3d.js) und Methoden, da die große Menge an Daten in „Big Data“-Applikationen häufig nicht mehr in einfachen Graphen dargestellt werden kann.

- Statistische Methoden beschreiben die Anwendung von mathematischen Theorien wie Wahrscheinlichkeits- und Zufälligkeitsrechnungen bis hin zu komplexeren multivarianten Analysen.

- Unter dem Begriff „Data Mining“ werden unterschiedlichste Algorithmen zusammengefasst, die von einfachen Klassifikationsalgorithmen über Clustering und Regression bis hin zu statistischen Lernmethoden reichen. In den letzten Jahren wurden diese Algorithmen um die Kategorie der sogenannten „Deep Learning“ Methoden erweitert. Diese umfassen z.B. generische Algorithmen und neuronale Netze.

Die am häufigsten verwendeten Algorithmen wurden in (Wu et al., 2007) aufgelistet.

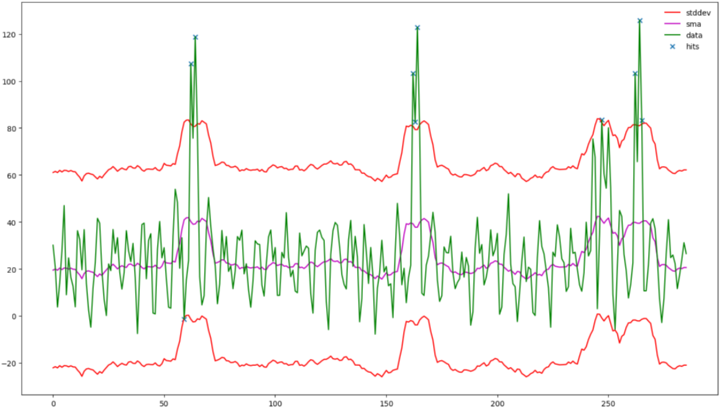

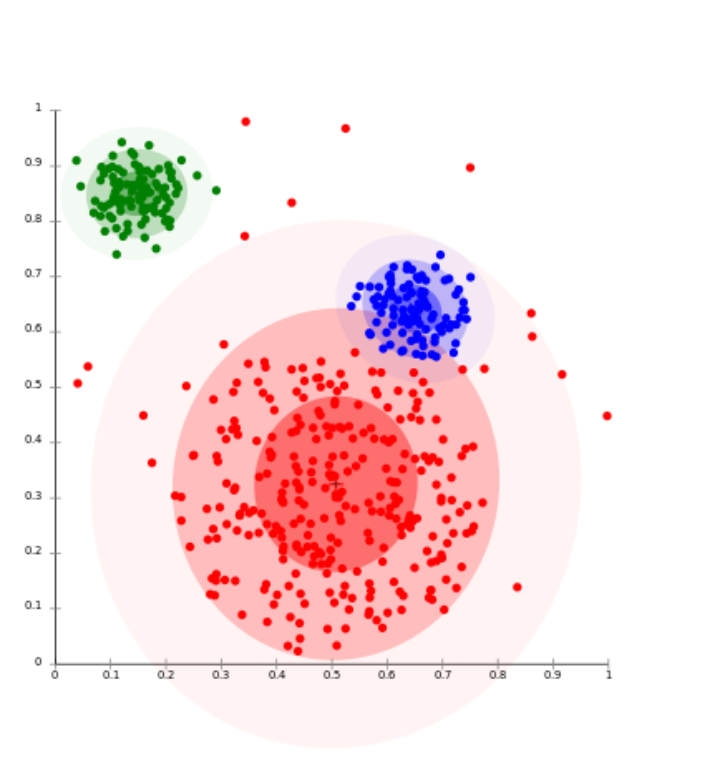

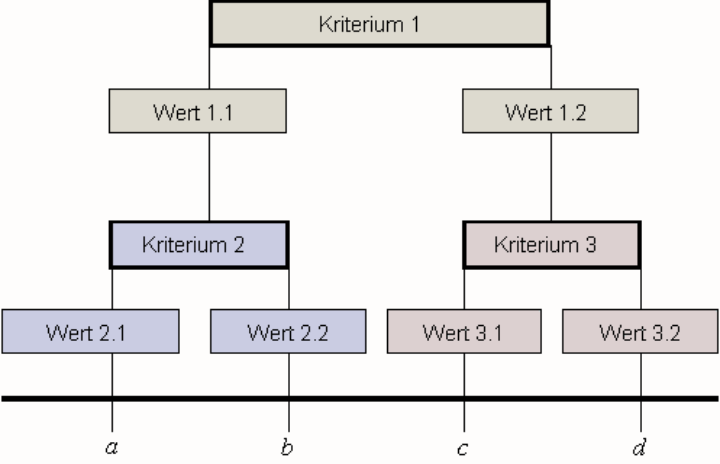

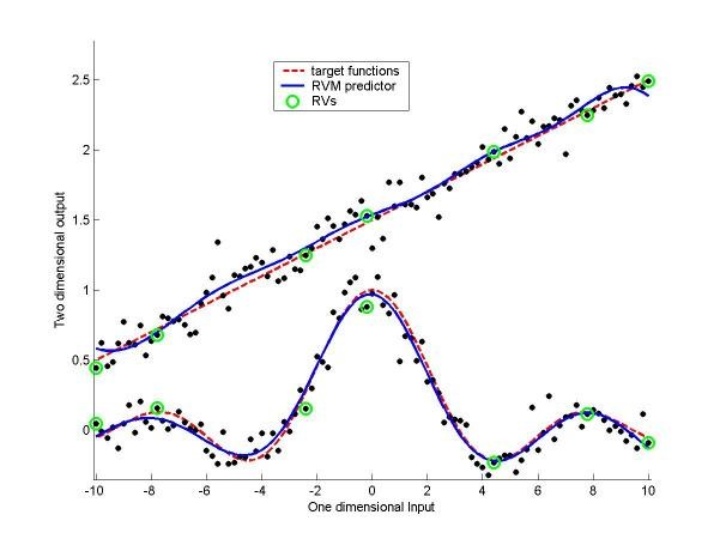

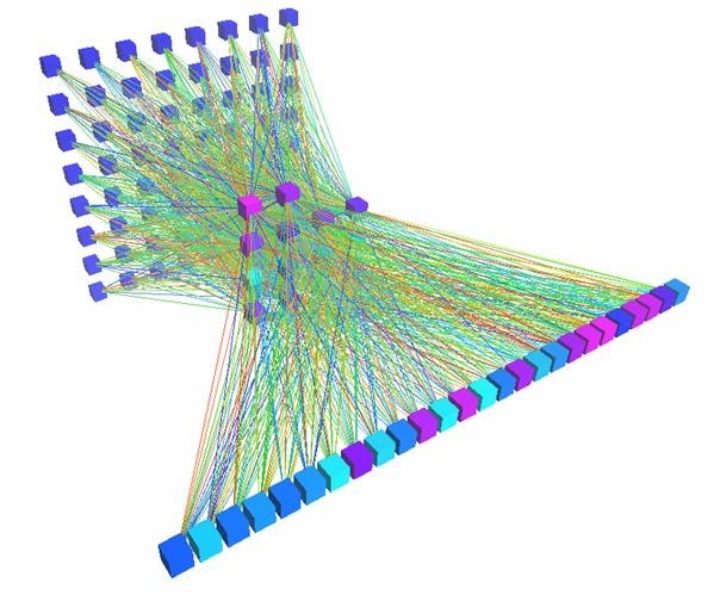

Einige der oben genannten Anwendungsbereiche sollen hier kurz erläutert und graphisch veranschaulicht werden:

- Anomalieerkennung durch Identifizierung von inkonsistenten Daten, d.h. Ausreißer, Fehler oder große Änderungen.

- Clusteranalyse: Gruppierung von Objekten aufgrund von Ähnlichkeiten.

- Klassifikation: Ordnet bisher nicht zugeordnete Elemente bestehenden Klassen zu.

- Regressionanalyse: Modelliert die statischen Zusammenhänge zwischen unterschiedlichen Attributen.

- Deep Learning / neuronale Netze: Algorithmen für das Lernen und Klassifizieren von Daten anhand von Trainingsdaten. Inspiriert durch das menschliche Gehirn.

Fazit

Die vielseitigen und inzwischen einfach zugänglichen Methoden der „Data Analysis“ haben enormes Potential für Optimierungen und informierte Entscheidungen in nahezu allen Bereichen unserer Gesellschaft. Die hauptsächliche Herausforderung liegt hierbei weniger in der technischen Umsetzung der Analyse als vielmehr in der Identifizierung der sinnvollen und produktiven Einsatzbereiche der beschriebenen Technologien. Da sich „Data Analysis“ auf nahezu beliebige Datensätze mit variabler Größe anwenden lässt, ist es umso wichtiger, sich vorab klar zu werden, welche Aussagen und Informationen aus der Analyse gewonnen werden sollen. Bei richtiger Anwendung und gleichzeitigem Ausbau der Dateninfrastruktur im Bereich des Cloudcomputing ist ein weiteres Wachstum im Bereich „Data Analysis“ aufgrund der Wettbewerbsvorteile, die sich durch die Technologie ergeben, in Verbindung mit den realen Optimierungspotentialen, z.B. im Bereich des Energieverbrauchs oder der Verkehrsplanung, unausbleiblich.

Literaturverzeichnis

- al., K. e. (2014). Trends in big data analytics. Elsevier.

- Hu, H., Wen, Y., Chua, T.-S., & Li, X. (2014). Toward Scalable Systems for Big Data Analytics: A Technology Tutorial. Singapore: IEEE.

- Russom, P. (2011). Big Data Analytics - TDWI Best Practices Report. Renton, Washington: The Data Warehousing.

- Wu et al., X. (2007). Top 10 algorithms in data mining. London: Springer.

Quellen

Dieser Beitrag entstand nach einem Vortrag im Rahmen der Ringvorlesung „Forum Software und Automatisierung“ am IAS.

Vortragsdatum: 27.10.2016

Vortragender: Stefanie Brauner & Dr. Luisa Oggero, GEMMACON

Vortragstitel: Wege der Digitalisierung – Quality Analytics