Inhaltsverzeichnis

Abstract

Mit der wachsenden Menge an produzierten Daten wächst ebenfalls das Bedürfnis, diese Datenmengen effizient nutzen zu können. Dieses Paper beschäftigt sich zunächst damit, was unter dem Begriff Big Data zu verstehen ist. Im Anschluss daran wird Big Data in den Kontext von Real-Time-Analysen gestellt, um anschließend den Analyseprozess von Big Data darzulegen. Danach wird Apache Hadoop als meistverwendete Software betrachtet. Abschließend wird das Thema analysiert und ein Ausblick in die Zukunft gegeben sowie ein Fazit gezogen.

Motivation / Auslöser

Die Menge an Daten, die generiert und gespeichert werden, steigt exponentiell an. Die Wachstumsrate erhöht sich um mehr als das Doppelte innerhalb von 18 Monaten. Durch diese rasant ansteigenden Datenmengen eröffnen sich Unternehmen neue Möglichkeiten, diese Daten zu nutzen, um einen Mehrwert für das Unternehmen zu schaffen. Der Fokus der meisten Unternehmen lag vor dem Wandel auf der Analyse von strukturierten Daten. Durch diese Entwicklung stieg jedoch die Menge an unstrukturierten Daten, die produziert werden, stark an. Das zentrale Merkmal von Big-Data-Analysen liegt nicht nur darin, größere Datenmengen verarbeiten zu können, die zuvor nicht durch moderne Technologien verarbeitet werden konnten, sondern ebenfalls darin, verschiedene Arten von strukturierten und unstrukturierten Daten miteinander in Einklang zu bringen. [1]

Herkömmliche Architekturen von Softwaresystemen haben nicht die notwendige Architektur, um mit diesen neuartigen Datensets umgehen zu können. Daher definieren sich die Eigenschaften einer Architektur, die Big Data verarbeiten kann, durch die sogenannten vier „Vs“: Volume, Variety, Velocity und Variability. Volume steht für die Größe der Datenmengen, Variety für Daten aus unterschiedlichsten Quellen, Velocity für die Geschwindigkeit, in der die Datenmengen produziert werden, und Variability für die Änderungen der Eigenschaften der Daten. [1]

Diese Datenmengen fließen aus verschiedenen Datenquellen zusammen, unter anderem aus internen und externen Systemen oder aus dem Web. Dadurch können potentiell wichtige Informationen gewonnen werden, wenn die Daten effektiv gesammelt und aggregiert werden. Daher ist für Unternehmen erforderlich, relevante Informationen aus Big Data zu extrahieren, um ihre Entscheidungsfindung zu verbessern und somit Wettbewerbsvorteile gegenüber ihren Konkurrenten zu generieren. [2]

Stand der Technik

Dieses Kapitel beschäftigt sich damit, wie Unternehmen diesen vorher genannten Wettbewerbsvorteil erzielen können, um bessere Entscheidungen treffen zu können. Zunächst wird näher erläutert, in welchem Zusammenhang Big Data und Real-Time-Analysen stehen. Anschließend wird auf den Prozess des Big Data Mining näher eingegangen.

Die Velocity von Big Data beschreibt die Rate, in der neue Daten generiert werden, und in welcher Geschwindigkeit sie analysiert werden sollten, um angemessen auf erkannte Muster oder Veränderungen in den Datenstrukturen reagieren zu können. Durch die enorm angestiegene und stets weiterwachsende Anzahl von Smartphones und Sensoren ist die Rate der Datenkreierung explodiert. Mit diesem Anstieg wächst der Bedarf an Systemen, die solche Datenmengen in Real-Time verarbeiten können, um die Veränderungen und Trends sofort zu erkennen. Dadurch ergeben sich Möglichkeiten, wie zum Beispiel die Erstellung von personalisierten Angeboten, unter anderem in Abhängigkeit von den geographischen Daten oder dem Kaufverhalten in der Vergangenheit. [3]

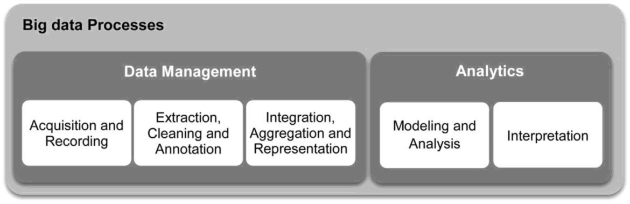

Wie der Prozess aussieht, mit den verschiedenen Eigenschaften von Big Data umzugehen, wird im nächsten Abschnitt beschrieben. Der Prozess, um Erkenntnisse aus den Daten gewinnen zu können, wird in Abbildung 1 dargestellt.

Der Prozess gliedert sich in die zwei Teilprozesse „Data Management“ und „Analytics“ mit insgesamt fünf verschiedenen Schritten. Der erste Teilprozess „Data Management“ beinhaltet die nötigen Prozesse und Technologien, um Daten zu erhalten, zu speichern und für die Analyse aufzubereiten. Zunächst werden die Daten gesammelt zusammengetragen. Im nächsten Schritt können die relevanten Daten extrahiert und gesäubert werden, indem sie in das gewünschte Format übertragen werden. Im Anschluss daran können die Daten aggregiert werden, um die passenden Analysen im nächsten Schritt durchführen zu können. Darüber hinaus können die Daten ebenfalls deskriptiv dargestellt werden.

Der zweite Teilprozess „Analytics“ referenziert die nötigen Technologien, um die Daten schlussendlich zu verarbeiten, zu analysieren und somit Einsichten zu gewinnen. [3] Dabei werden unterschiedliche Modelle, die auf der zuvor definierten Datengrundlage arbeiten, erstellt, die wiederum analysiert und interpretiert werden können, um somit die Erkenntnisse zu erweitern und den Entscheidungsprozess zu verbessern. Dabei gibt es verschiedene Analysetechniken, mit denen strukturierte und unstrukturierte Daten ausgewertet werden können. Zu den Analysetechniken gehören die Text-, Audio- und Video-Analyse sowie Analysen sozialer Medien und „Predictive Analytics“.

Für Big-Data-Analysen stehen verschiedene Open-Source-Systeme zur Verfügung. Große Unternehmen wie Facebook, Yahoo, Twitter und LinkedIn leisten Beträge zur Entwicklung dieser Open-Source-Lösungen und profitieren gleichermaßen davon. [4] Eines der am weitesten verbreiteten Tools ist Apache Hadoop.

Apache Hadoop wird für datenintensive verteilte Systeme genutzt und basiert auf dem von Google entwickelten MapReduce Model sowie einem Dateisystem namens „Hadoop Distributed Filesystem“. Hadoop ermöglicht es, Applikationen zu entwicklen, die parallel große Datenmengen auf verschiedenen Clustern berechnen. Googles‘ MapReduce wird dabei verwendet, um die Datenmengen in kleinere unabhängige Datensets zu unterteilen, die anschließend auf die Cluster verteilt werden können. [4]

Analyse, Diskussion und Bewertung

Wie im vorherigen Kapitel aufgezeigt, steigen die zur Verfügung stehenden Datenmengen immer weiter an, wodurch die Analyse dieser Daten auch in Zukunft eine große Rolle spielen wird. Viele Unternehmen nutzen das Potential bisweilen nur sehr wenig oder gar nicht, wodurch ihnen gegenüber ihren Konkurrenten ein möglicherweise entscheidender Wettbewerbsvorteil entgeht. Kritisch zu betrachten ist hierbei, dass Unternehmen, die in ihrer Branche das qualitativ hochwertigste Produkt produzieren oder bereitstellen, potentiell in das Hintertreffen geraten können, da durch fehlende Real-Einsichten auf den Markt und ihre Kunden ihre Konkurrenz bedeutend schneller und präziser agieren kann. Daher ist es wichtig, Unternehmen für dieses Thema zu sensibilisieren, damit sie diese Chance nicht ungenutzt lassen.

Weiterhin wird es in Zukunft wichtig sein, eine große Vielfalt an Analysetechniken und Softwareframeworks zur Verfügung zu haben, um die immer komplexer werdenden Datenstrukturen und Mengen bewältigen zu können.

Fazit

Zunächst wurde dargelegt, wieso das Thema Big Data in den letzten fünf Jahren massiv an Bedeutung gewonnen hat. Dabei wurde aufgezeigt, dass Architekturen herkömmlicher Systeme nicht ausgelegt sind, um Big Data analysieren zu können. Im nächsten Teil des Papers wurden die Eigenschaften von Big Data definiert. Danach wurde näher auf den Analyseprozess von Big Data eingegangen. Im Anschluss wurde aufgezeigt, dass Big Data eng mit Open-Source-Projekten verbunden ist und dass große Unternehmen dazu beitragen. Weiterhin wurde Apache Hadoop als Open-Source-Tool vorgestellt, da es zu den Softwarelösungen gehört, die am wichtigsten sind und am meisten Einfluss haben. Abschließend wurde das Thema analysiert und ein Ausblick in die Zukunft gegeben.

Literatur

- [1] NIST Big Data Interoperability Framework: Volume 1, Definitions, NIST Big Data Public Working Group Definitions and Taxonomies Subgroup , 2015.

- [2] Muhammad Mazhar Ullah Rathore, Anand Paul, Senior Member, IEEE, Awais Ahmad, Student Member, IEEE, Bo-Wei Chen, Member, IEEE, Bormin Huang, and Wen Ji, Member, IEEE, „Real-Time Big Data Analytical Architecture for Remote Sensing Application,“ IEEE JOURNAL OF SELECTED TOPICS IN APPLIED EARTH OBSERVATIONS AND REMOTE SENSING, VOL. 8, NO. 10, OCTOBER 2015, pp. 4610-4621, 2015.

- [3] Amir Gandomi, Murtaza Haider, „Beyond the hype: Big data concepts, methods, and analytics,“ International Journal of Information Management, pp. 137-144, 2014.

- [4] A. Bifet, „Mining Big Data in Real Time,“ Yahoo! Research Barcelona, Barcelona, 2013.

Quellen

Dieser Beitrag entstand nach einem Vortrag im Rahmen der Ringvorlesung „Forum Software und Automatisierung“ am IAS.

Vortragsdatum: 14.12.2017

Vortragender: Dr. Luisa Oggero und Dr. Friedemann Keyl, GEMMACON

Vortragstitel: Interaktive Datenanalyse